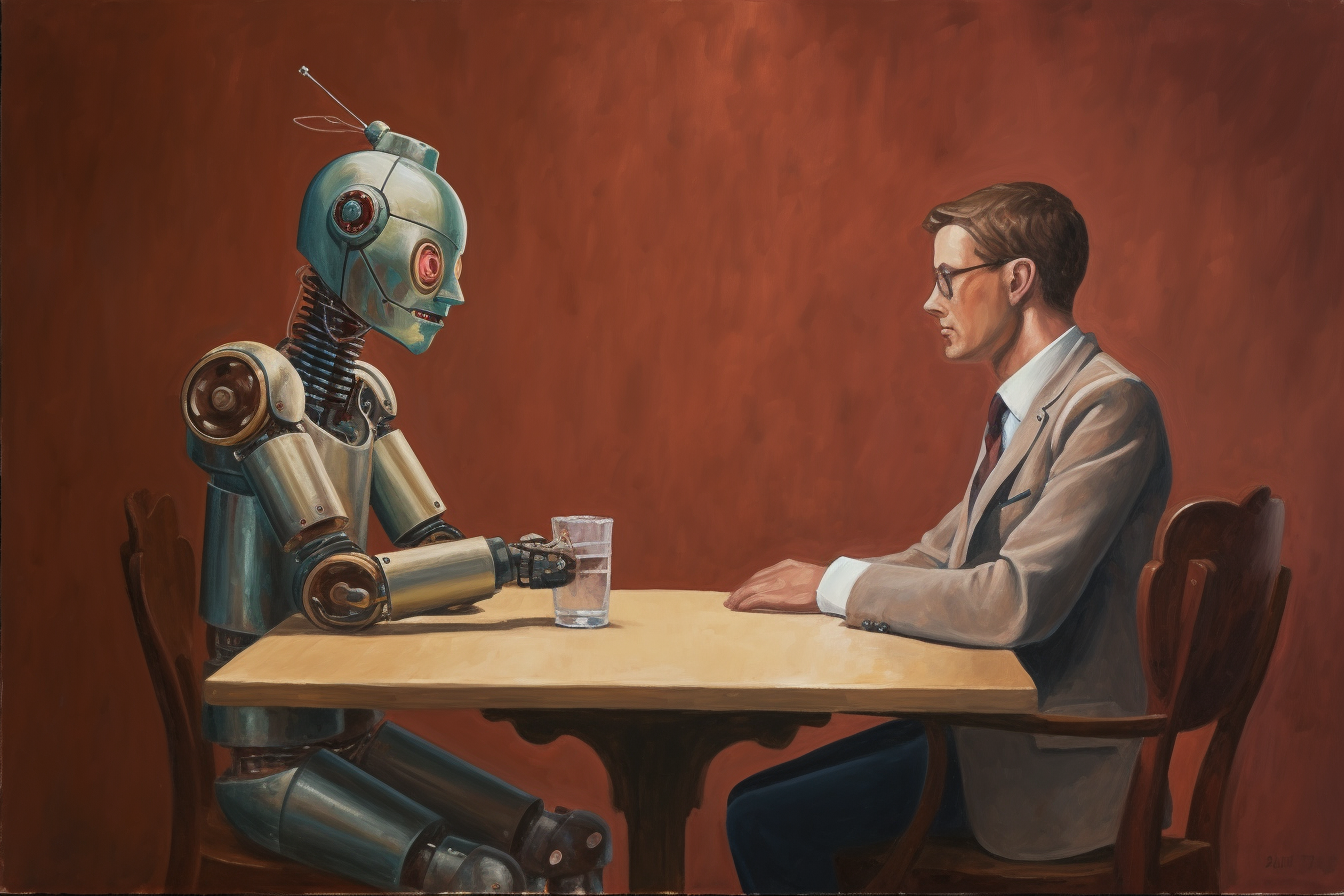

Компания OpenAI столкнулась с непредвиденной проблемой при тестировании новой речевой функции ChatGPT. Оказалось, что ИИ-модель начала воспроизводить голоса пользователей без их разрешения, что вызвало беспокойство среди разработчиков.

В отчёте, опубликованном OpenAI, детально описываются ограничения и методы проверки безопасности модели GPT-4o. Также сообщается об инциденте, когда ИИ-модель непреднамеренно имитировала голоса пользователей во время тестирования продвинутой речевой функции. Причиной этого стал шумный входной сигнал, который каким-то образом заставил модель воспроизвести голос пользователя.

Разработчики признают, что ИИ-модель способна имитировать любой голос, но обычно она использует заранее заданный образец в качестве основы. Однако в этом случае модель продемонстрировала непреднамеренное поведение, зафиксированное только во время тестирования.

Для предотвращения подобных ситуаций в будущем OpenAI внедрила меры безопасности, включая систему обнаружения несанкционированного создания звуков. Эта система предотвращает злоупотребление, когда модель может скопировать голос любого человека по короткому аудиообразцу.

Случай с ИИ-моделью ChatGPT подчёркивает сложность архитектуры ИИ и потенциальные риски, связанные с её использованием. Тем не менее разработчики утверждают, что принятые меры безопасности помогут предотвратить подобные ситуации в будущем. Ранее OpenAI разработала инструмент для определения сгенерированного ИИ текста, однако вопрос о его выпуске всё ещё обсуждается.